Reading Time: 4 minutesCome in molti sapranno, Intel utilizza un particolare modell Tick Tock per lo sviluppo dei suoi micro-processori: un tick comporta miglioramenti nel processo produttivo, un tock lo sviluppo di una nuova micro-architettura. Questo si traduce normalmente in un miglioramento nelle prestazioni durante un tick (dato una maggiore frequeza di lavoro e a volte anche da un maggior numero di core e/o in una cache più capiente) e nell’introduzione di nuove funzionalità durante un tock (ma non necessariamente in un miglioramento della frequenza e/o del numero di core e/o della cache).

L’aspetto sicuramente interessante è che dopo qualche mese dal rilascio di una nuova generazione (tick o tock che sia), normalmente i prezzi dei nuovi processori diventano comparabili o persino concorrenziali a quelli della generazione precedente.

A complicare però questo modello semplice e lineare, vi è stata la famiglia dei processori Westmere (che dovrebbe essere semplicemente l’evoluzione tick della famiglia Nehalem) che in realtà si è articolata in varie sotto-famiglie, tra cui almeno due grosse varianti Xeon: Westmere-EP (che effettivamente collima con un’evoluzione tick del modello precedente) e Westmere-EX (la serie Xeon E7, che in realtà è più simile ad un’evoluzione di tipo tock).

Ad aggiungere ulteriore confusione la scelta di chiamare l’effettiva generazione tock con il nome di Xeon E5. Questo rende più complesso il paragone con la famiglia E7 (che ricordiamo essere più datata), per tutta una serie di ragioni: i numeri non aiutano (sembra che E7 sia quanto meno più “potente”), la cache sugli E7 è in effetti maggiore(24 MB contro i 20MB degli E7), la memoria degli E7 è più “lenta” (persino paragonandola ai “vecchi” Westmere-EP).

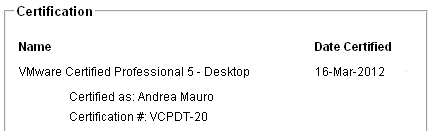

Ma il confronto più interessante sia ha lato prezzi: se confrontiamo un E5-2670 (Recommended Customer Price: $1552 – $1556) con un E7-4830 (Recommended Customer Price: $2059) il costo rende decisamente conveniente la nuova generazione. Confrontando poi le caratteristiche tecniche (vedere i datasheet sul sito Intel) ci si accorge che a parte il (lieve) svantaggio della cache) tutto il resto gioca a favore nella nuova generazione (considerando anche che corrisponde anche a nuove generazioni dei server):

| Product Name |

Intel® Xeon® Processor E5-2670 (20M Cache, 2.60 GHz, 8.00 GT/s Intel® QPI) |

Intel® Xeon® Processor E7-4830 (24M Cache, 2.13 GHz, 6.40 GT/s Intel® QPI) |

| Code Name |

Sandy Bridge-EP |

Westmere EX |

| Essentials |

| Status |

Launched |

Launched |

| Launch Date |

Q1’12 |

Q2’11 |

| Processor Number |

E5-2670 |

E7-4830 |

| # of Cores |

8 |

8 |

| # of Threads |

16 |

16 |

| Clock Speed |

2.6 GHz |

2.13 GHz |

| Max Turbo Frequency |

3.3 GHz |

2.4 GHz |

| Cache |

20 MB |

24 MB Intel® Smart Cache |

| Bus/Core Ratio |

33 |

16 |

| Bus Type |

QPI |

QPI |

| System Bus |

8 GT/s |

6.4 GT/s |

| # of QPI Links |

2 |

|

| Instruction Set |

64-bit |

64-bit |

| Instruction Set Extensions |

AVX |

SSE4.1/4.2 |

| Embedded Options Available |

No |

No |

| Lithography |

32 nm |

32 nm |

| Scalability |

2S Only |

S4S |

| Max TDP |

115 W |

105 W |

| VID Voltage Range |

0.60V-1.35V |

|

| Recommended Customer Price |

|

2059.00 |

| Memory Specifications |

| Max Memory Size (dependent on memory type) |

750 GB |

2048 GB |

| Memory Types |

DDR3-800/1066/1333/1600 |

DDR-3 800/978/1066/1333 (Max Speed 1066 MHz) |

| # of Memory Channels |

4 |

4 |

| Max Memory Bandwidth |

51.2 GB/s |

|

| ECC Memory Supported |

Yes |

Yes |

| Expansion Options |

| PCI Express Revision |

3.0 |

|

| Package Specifications |

| Max CPU Configuration |

2 |

4 |

| TCASE |

81.8°C |

64°C |

| Package Size |

52.5mm x 45.0mm |

49.17mm x 56.47mm |

| Sockets Supported |

FCLGA2011 |

LGA1567 |

| Low Halogen Options Available |

See MDDS |

See MDDS |

| Advanced Technologies |

| Intel® Turbo Boost Technology |

2.0 |

Yes |

| Intel® vPro Technology |

Yes |

|

| Intel® Hyper-Threading Technology |

Yes |

Yes |

| Intel® Virtualization Technology (VT-x) |

Yes |

Yes |

| Intel® Virtualization Technology for Directed I/O (VT-d) |

Yes |

|

| Intel® Trusted Execution Technology |

Yes |

Yes |

| AES New Instructions |

Yes |

Yes |

| Intel® 64 |

Yes |

Yes |

| Idle States |

Yes |

|

| Enhanced Intel SpeedStep® Technology |

Yes |

Yes |

| Intel® Demand Based Switching |

Yes |

|

| Thermal Monitoring Technologies |

Yes |

Yes |

| Intel® Flex Memory Access |

Yes |

|

| Execute Disable Bit |

Yes |

Yes |

Per i primi dati (al momento solo nel mercato desktop) sulla generazione successiva vedere (in inglese): Unofficial Intel Ivy Bridge CPU Datasheet.